如果TTS/ASR语音合成与识别算作一种AI早期应用的话,联络中心对于应用新科技还真是比较热衷并扎扎实实推进的:

场景1:客户呼入服务Inbound IVR

比如笔者打电话XX银行查询余额时候(工资日...)总会有TTS语音播报:

请输入您要查询的币种,人民币请按1,美元请按2,您也可以直接说“人民币”

不仅如此,它还会有“人民币,确认请按1....”的神逻辑。

场景2:主动呼出服务Proactive Outbound

比如笔者申请的信用卡收到后,XX银行会自动外呼给我,也是TTS语音播报:

如需激活信用卡,请直接说:“我已了解并确认激活”。

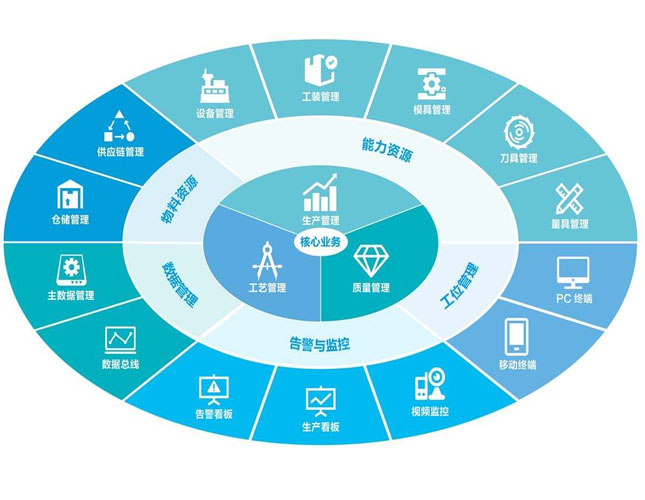

技术想象力在联络中心AI应用可谓无穷无尽,有多少人工,就有多少智能:

语音识别领域,有一个置信度Confidence的指标,意在IVR服务器通过MRCP协议连接ASR语音引擎时,获取ASR引擎对用户语音识别的把握度。随着ASR语音引擎的confidence越来越高的时候,DTMF确认的环节可以忽略,直接识别并作出响应。不过置信度的提高是有极限的,有时候客户不说普通话或者中英混杂,而客户会假定企业服务的AI无比智能,因为你已经让他可以免按键直接说就可以了。这个时候就需要对客户的期望进行管理了!

程序猿一般会在IVR语音菜单中配以迂回路由来解决问题。通常的做法是使用标准化语音宣告:“对不起,我不能准确理解您的意思,请您用普通话并降低语速在重复一遍”。如果用户第二次语音输入系统依然无法理解,系统会第二次再宣告一遍。如果用户第三次依然如故……系统可以选择转接人工坐席,或者转接常规IVR-按键菜单,或者直接I语音宣告:对不起,尝试次数已达到上限,请您稍后再拨…

不过,笔者见过一种更加聪明的做法:

当ASR语音识别或者后台语义识别(知识库检索)不准确时,运行VXML的媒体服务器Media Server实时获取ASR引擎返回的confidence置信度指标,判断异常低于门限时,主动邀请专门的人工坐席静默接入...hmm,专业进行语音数据打标签的人工坐席。这种特殊的静默坐席可以准确听到并理解客户的语音输入,同时与后台引擎进行数据交互,帮助用户继续与ASR会话。通话结束后,后台的AI再进行新一轮数据反哺并分析。语音数据折叠,因为人更能理解人的说话。

文本聊天机器人领域,应用场景也类似:

首先当用户进行文本聊天页面时,就会有文本菜单进行主动引导,在打字输入时还会有常用问句提示。后端的chatbot利用NLP引擎结合专业知识库的检索,回答用户问题或准确传递知识库中的相关回复。如果chatbot遇到知识库没有覆盖到的问题,系统会进行多种处理方式:

有的AI方案会使用抖机灵的做法,诸如“这个问题太难了,我得回家问我妈”之类。客观来说,抖机灵更适合通用型的聊天机器人,在专业客户服务领域并不适合。

通常情况下,聊天机器人/聊天服务器会邀请人工坐席介入聊天。实际上,用户对聊天机器人的体验和期望值会降低。客户会看见人工坐席加入到聊天室,导致一个结果,后面客户一上来就会在聊天框里就输入两个字“人工”。

有没有一种方法?让客户跟机器人聊天,当机器人不给力时,人工坐席自动介入并获取整个交谈全过程,并做出更加个性化和更加准确的服务,整体提升AI的利用率和客户的有效体验值?

必须有,关注用户体验不仅在AI后台持续优化,联络中心平台也可以发力。

G厂创新地推出了KATE方案,AI Bot Gateway可以同时接入多家AI的机器人平台(注意!是同时哦)。Bot Gateway可以实时获取NLP机器人的Confidence/Timeout等参数并作出实时决策自动切换至人工坐席。人工介入帮助客户解决问题后,还可以无缝进一步连接下一步流程。

有一个小插曲,看到G厂的AI Gateway还可以连接微软的BING Translate AI,助力中国企业服务全球用户,用户说英文,坐席说中文,两不耽误,特别有趣。

人工智能在联络中心应用方兴未艾,只有海纳百川的态度,才能杜绝技术高垒墙,AI Gateway协助联络中心客户体验平台更进一步,拥抱AI。

场景1:客户呼入服务Inbound IVR

比如笔者打电话XX银行查询余额时候(工资日...)总会有TTS语音播报:

请输入您要查询的币种,人民币请按1,美元请按2,您也可以直接说“人民币”

不仅如此,它还会有“人民币,确认请按1....”的神逻辑。

场景2:主动呼出服务Proactive Outbound

比如笔者申请的信用卡收到后,XX银行会自动外呼给我,也是TTS语音播报:

如需激活信用卡,请直接说:“我已了解并确认激活”。

技术想象力在联络中心AI应用可谓无穷无尽,有多少人工,就有多少智能:

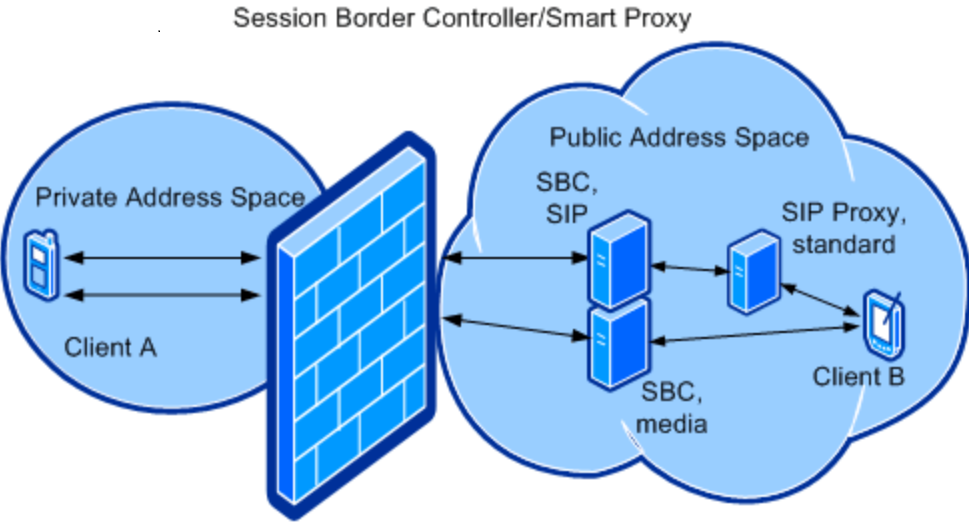

语音识别领域,有一个置信度Confidence的指标,意在IVR服务器通过MRCP协议连接ASR语音引擎时,获取ASR引擎对用户语音识别的把握度。随着ASR语音引擎的confidence越来越高的时候,DTMF确认的环节可以忽略,直接识别并作出响应。不过置信度的提高是有极限的,有时候客户不说普通话或者中英混杂,而客户会假定企业服务的AI无比智能,因为你已经让他可以免按键直接说就可以了。这个时候就需要对客户的期望进行管理了!

程序猿一般会在IVR语音菜单中配以迂回路由来解决问题。通常的做法是使用标准化语音宣告:“对不起,我不能准确理解您的意思,请您用普通话并降低语速在重复一遍”。如果用户第二次语音输入系统依然无法理解,系统会第二次再宣告一遍。如果用户第三次依然如故……系统可以选择转接人工坐席,或者转接常规IVR-按键菜单,或者直接I语音宣告:对不起,尝试次数已达到上限,请您稍后再拨…

不过,笔者见过一种更加聪明的做法:

当ASR语音识别或者后台语义识别(知识库检索)不准确时,运行VXML的媒体服务器Media Server实时获取ASR引擎返回的confidence置信度指标,判断异常低于门限时,主动邀请专门的人工坐席静默接入...hmm,专业进行语音数据打标签的人工坐席。这种特殊的静默坐席可以准确听到并理解客户的语音输入,同时与后台引擎进行数据交互,帮助用户继续与ASR会话。通话结束后,后台的AI再进行新一轮数据反哺并分析。语音数据折叠,因为人更能理解人的说话。

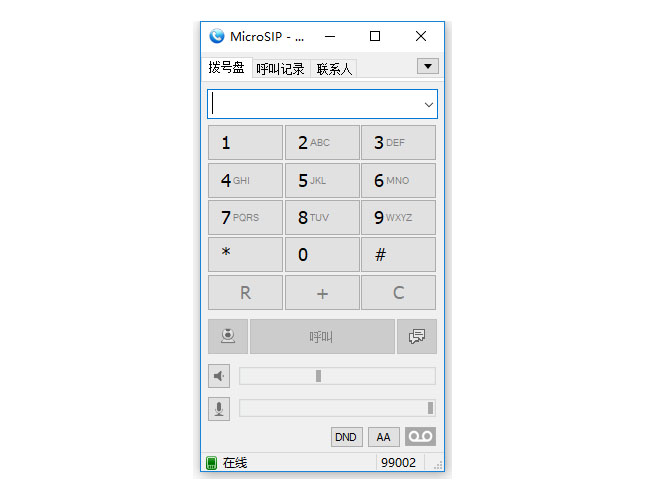

文本聊天机器人领域,应用场景也类似:

首先当用户进行文本聊天页面时,就会有文本菜单进行主动引导,在打字输入时还会有常用问句提示。后端的chatbot利用NLP引擎结合专业知识库的检索,回答用户问题或准确传递知识库中的相关回复。如果chatbot遇到知识库没有覆盖到的问题,系统会进行多种处理方式:

有的AI方案会使用抖机灵的做法,诸如“这个问题太难了,我得回家问我妈”之类。客观来说,抖机灵更适合通用型的聊天机器人,在专业客户服务领域并不适合。

通常情况下,聊天机器人/聊天服务器会邀请人工坐席介入聊天。实际上,用户对聊天机器人的体验和期望值会降低。客户会看见人工坐席加入到聊天室,导致一个结果,后面客户一上来就会在聊天框里就输入两个字“人工”。

有没有一种方法?让客户跟机器人聊天,当机器人不给力时,人工坐席自动介入并获取整个交谈全过程,并做出更加个性化和更加准确的服务,整体提升AI的利用率和客户的有效体验值?

必须有,关注用户体验不仅在AI后台持续优化,联络中心平台也可以发力。

G厂创新地推出了KATE方案,AI Bot Gateway可以同时接入多家AI的机器人平台(注意!是同时哦)。Bot Gateway可以实时获取NLP机器人的Confidence/Timeout等参数并作出实时决策自动切换至人工坐席。人工介入帮助客户解决问题后,还可以无缝进一步连接下一步流程。

有一个小插曲,看到G厂的AI Gateway还可以连接微软的BING Translate AI,助力中国企业服务全球用户,用户说英文,坐席说中文,两不耽误,特别有趣。

人工智能在联络中心应用方兴未艾,只有海纳百川的态度,才能杜绝技术高垒墙,AI Gateway协助联络中心客户体验平台更进一步,拥抱AI。